ChatGPTは便利なツールですが、セキュリティリスクと無縁ではありません。

ChatGPTを利用したハッキングや機密情報の漏えいは、大企業や政府機関でも問題視されています。個人ユーザーでも気づかないうちに機密情報を提供してしまうケースが増えており、漏えいを招いた実例も報告されています。

ChatGPTを安全に活用するためには、潜在的なリスクを理解することが不可欠です

本記事では、ChatGPTを安心して利用するために必要なセキュリティ知識と、実践可能な具体策を解説します。

ChatGPTの仕組みとセキュリティリスク

ChatGPTでは、入力された内容が運営元のOpenAIに送信されます。同社は高いセキュリティを整備しており、社員でもデータにアクセスできない仕組みとなっています。ただし、OpenAIがサイバー攻撃の標的になることで、個人情報流出のリスクが完全にないとは言い切れません。

そのため、利用する際は氏名や住所、連絡先など、プライバシーに関する情報を入力しないことが推奨されます。

ChatGPTで実施されているセキュリティ対策

OpenAIは、利用者のプライバシーを保護するために、以下のようなセキュリティ対策を実施しています。

データの保護とプライバシー管理

ChatGPTは利用者から入力されたデータや会話履歴を、暗号化技術を用いて安全に管理しています。また、個人情報が許可なく第三者に漏洩することを防止するため、情報へのアクセスを制限し、管理を徹底しています。特に個人を特定できる情報や機密性の高い情報については、匿名化や削除措置を行い、厳格なデータ管理ポリシーを設定しています。

さらに、データベースやサーバーへのアクセスは、認証を受けた担当者のみが可能な仕組みとなっており、不正アクセスの防止を徹底しています。

システムのセキュリティ強化と不正アクセス対策

ChatGPTを運用するサーバーやネットワークには、外部からの攻撃を防ぐためのファイアウォール、侵入検知システム(IDS)、異常検知技術などが導入されています。また、ログ監視やリアルタイムのセキュリティモニタリングを実施し、不審なアクセスや挙動を早期に検出・対応できる体制を整えています。

加えて、多要素認証や厳密なアクセス権限設定など、認証システムを高度化しており、システムへの不正アクセスやデータ漏洩を防ぐための対策を継続的に強化しています。

AIモデルの安全性確保とインシデント対応

ChatGPTのAIモデルに対しては、安全性を評価するための厳密なテストが実施されています。不適切な指示や有害なプロンプト(プロンプトインジェクション攻撃)に対応するため、入力内容の監視やフィルタリングを行い、悪用を防止しています。

また、AIモデルが予期せぬ行動や有害な出力をしないように、モデルの安全性評価を定期的に実施し、改善を継続しています。万が一問題が発生した場合も、迅速に対応できるインシデント対応体制を整備し、被害や影響を最小限に抑える取り組みを行っています。

ChatGPTのセキュリティについて懸念されていること

OpenAIで講じられているものとはいえ、残念ながらその対策は万全とは言えません。ChatGPTのセキュリティについて、世間で懸念されていることについて解説します。

個人情報や機密情報の漏えい

ChatGPTに企業の機密情報や個人情報を入力すると、そのデータはAIの学習用データベースに記録・蓄積されます。特にWeb版では、ユーザーが入力した情報が継続的に学習材料として利用されるため、意図せず他のユーザーへの回答として情報が流出する恐れがあります。

実際、ある調査によれば、従業員の6.5%がChatGPTに機密情報を入力した経験があると回答しています。公式でも「機密情報を入力しないよう」明記しており、アカウント作成時点で情報漏洩のリスクは完全には排除できません。

サイバー攻撃へ悪用される

ChatGPTは高度な言語生成能力を持つため、フィッシングメールやマルウェアの作成など、サイバー攻撃に悪用される懸念があります。本来、AIは不適切な内容を拒否する設定が施されていますが、巧妙な指示を与えることで規制を回避し、不正なメールや攻撃用文書を作成することも可能です。

こうした手法は今後ますます広がることが予測されており、結果としてWeb上の犯罪が増加する可能性が指摘されています。企業や個人が標的となる情報収集にも利用される危険性があります。

誤った情報の拡散

ChatGPTは2021年9月までのデータを学習しているため、最新情報への対応が不十分で、誤った情報を発信するリスクが伴います。特に医療や法律など専門性の高い領域で誤情報が流布された場合、深刻な影響を及ぼす可能性があります。また、こうした誤情報が企業や個人の信頼性を損ない、ブランドの失墜を招く恐れもあります。

公式においてもChatGPTが不正確な情報を出力する可能性があることが明記されており、依存しすぎることによる危険性が指摘されています。

ChatGPTで実際に起こったセキュリティ問題

ChatGPTの利用に関連して、情報漏えいやサイバー攻撃などのセキュリティ問題がいくつか報告されています。以下に主な事例を紹介します。

①OpenAIによるデータ漏洩

2023年3月20日、OpenAIが使用していたRedisオープンソースライブラリのバグにより、ChatGPT Plusの有料ユーザー約1.2%(推定100万人以下)のチャット履歴や個人情報(氏名、メールアドレス、支払い住所、クレジットカード情報の一部)が他のユーザーに表示される事態が発生しました。 OpenAIは問題発覚後、ChatGPTサービスを一時停止し、バグの修正や影響を受けたユーザーへの通知、セキュリティ対策の強化を行いました。

②サムスン電子の機密情報漏えい事件

2023年、サムスン電子(Samsung)の従業員がChatGPTに機密情報を入力した結果、情報が外部に漏えいする事件が発生しました。具体的には、社内のソースコードや会議内容などがChatGPTを通じて流出しました。この事件を受け、サムスン電子はChatGPTの社内利用を一時的に禁止し、セキュリティ対策を強化しました。

③ChatGPTアカウント情報の闇市場流出

シンガポールのセキュリティ企業Group-IBは、約10万件のChatGPTアカウント情報がダークウェブの闇市場で売買されていることを発見しました。これらの情報は、インフォスティーラーと呼ばれるマルウェアによって盗まれたもので、フィッシング詐欺などの悪用が懸念されています。

④フェイクニュースの生成と拡散

中国では、ChatGPTを利用して作成された偽のニュース記事がSNS上で拡散され、混乱を引き起こす事例が報告されています。例えば、杭州市が自動車の通行制限を撤廃するという偽情報が流れ、多くの住民が誤解しました。このようなフェイクニュースの生成は、情報操作や社会的混乱を招く可能性があります。

⑤マルウェアの作成

セキュリティ研究者は、ChatGPTを利用して高度なマルウェアを短時間で生成できることを実証しました。ChatGPTは悪質なプロンプトを拒否する機能を備えていますが、巧妙な入力によってこの制限を回避し、悪意のあるコードを生成することが可能であると指摘されています。

実践できるChatGPTのセキュリティ対策

ChatGPTでのセキュリティ対策に加え、ユーザー側でも対策を講じることで、より安全にChatGPTを利用することができます。

ここでは、個人利用者向けと企業向けに分けて、それぞれのセキュリティ対策について解説します。

個人向けの対策

個人がChatGPTを安全に利用するためには、個人情報の入力を控え、強固なパスワード設定やチャット履歴の適切な管理を徹底することが重要です。これにより、情報漏洩や不正アクセスのリスクを効果的に軽減できます。

個人情報の入力を避ける

ChatGPTは入力した情報を学習し、他のユーザーへの回答に使用する仕組みのため、個人情報や機密情報の入力は控えるべきです。機密情報がサーバーに保存されると、意図しない形で流出する可能性も否定できません。個人的な情報や企業名、重要な数値などはそのまま入力せず、ダミーの情報に置き換えることが推奨されます。例えば、実際の社名や人物名を架空の名前に変え、具体的な数字や日付も実在しないものに変更する工夫が必要です。

強固なパスワードを設定する

OpenAIアカウントへの不正アクセスを防ぐために、パスワードを強化することが重要です。パスワードは12文字以上の長さとし、大文字・小文字・数字・特殊文字を混ぜて設定します。また、推測されやすい個人情報は避けるよう注意が必要です。

強いパスワードの条件

・12文字以上の長さ

・大文字・小文字の混在

・数字、特殊文字の使用

・個人情報を含まない

例)田中太郎さん・4/20生まれの場合

×悪い例:tanakatarou0420、tanaka0420tatou

◎良い例:Ta04Na&Ka_Ta.Ro20、tana02tnK-tr40taro

さらに、多要素認証(MFA)を導入するとより強固なセキュリティとなります。アカウントの設定画面からセキュリティ設定を開き、多要素認証を有効化することで、アカウントの安全性が格段に向上します。

- OpenAIアカウントの設定画面を開く

- セキュリティ設定から多要素認証を選択

- 画面の指示に従って設定を完了

チャット履歴を管理する

ChatGPTのチャット履歴には、意図せず個人情報や機密情報が記録されていることがあります。過去の履歴から機密情報を完全に削除することができないため、定期的に履歴を確認し、機密情報が含まれないよう注意を払うことが必要です。

可能であれば定期的に履歴を削除するか、履歴を保存しない設定に切り替えることで、情報漏えいのリスクを抑えることができます。また、個人情報が含まれていないか確認する習慣をつけることも重要です。

企業向けの対策

企業がChatGPTを使用する場合、明確な利用ガイドラインを策定し、従業員に対する定期的な教育を実施することが不可欠です。また、これらを支援するセキュリティツールの導入により、リスクの早期発見と予防が可能となり、安全で効果的な活用が実現できます。

明確なガイドラインを策定する

企業内でのChatGPT利用に関する具体的なガイドラインを策定し、社内で共有・徹底することが必要です。ChatGPTの用途や、入力してはいけない情報、作成された文書の管理方法などを明記します。

セキュリティリスクは日々変化するため、ガイドラインを定期的に見直して更新することも重要です。また、策定したガイドラインを社内研修や資料で周知し、全従業員がルールを認識・遵守するよう促すことで、安全なChatGPTの活用を支援できます。

従業員教育を実施する

従業員がChatGPTを安全に活用できるよう、定期的なセキュリティ教育を実施しましょう。研修では、情報漏えいやサイバー攻撃への対応方法、個人情報の入力を避けることの重要性など、具体的なケースを示して啓発することが効果的です。

また、最新の事例を取り入れて、実際に起こりうるトラブルを理解させ、問題発生時の対応手順を明確化することも重要です。これにより、ChatGPT利用時のリスクを軽減できます。

セキュリティツールを導入する

企業内でのChatGPT利用に伴う情報漏えいを防ぐため、DLP(Data Loss Prevention)などのセキュリティシステムを導入すると効果的です。

DLPは、指定したデータを監視し、機密情報がコピーや送信されることを制限・防止します。特に社員が機密データをコピーしたり、ChatGPTに手入力しようとした場合に警告やブロックをかける機能があるため、内部漏えい防止に有効です。加えて、情報監視ソフトやChatGPT専用の監視ツールを導入することで、更に安全性を高めることができます。

ChatGPTで個人情報を入力してしまった場合の対策

万が一、個人情報や機密情報を入力してしまった場合、即時に対応することが重要です。また、再発防止のために対策を講じましょう。対応が遅れると、情報漏えいのリスクが高まります。

①チャットを即座に終了

ChatGPTに個人情報や機密情報を誤って入力した場合、まずはそのチャットをすぐに終了しましょう。チャットを終了することで、それ以上の情報がAIに送信されるのを防げます。

ただし、入力済みの情報はすでにサーバーに記録されている可能性があるため、これだけでは不十分です。即時終了はあくまで最初の応急措置として重要であり、その後の適切な対応や設定変更を迅速に行うことが求められます。

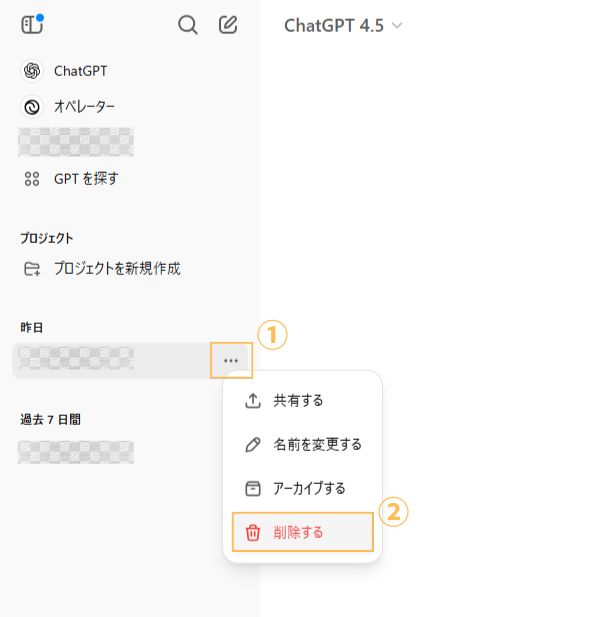

②チャット履歴の削除

誤って入力した個人情報をChatGPTから削除したい場合、対象となるチャット履歴を削除しましょう。

ただし、ChatGPTの仕様上、一部の情報は完全に削除できない場合があり、OpenAIのサーバーには履歴が残る可能性もあります。履歴削除はあくまで情報漏洩リスクを軽減する手段であり、今後は機密情報を含まないよう細心の注意を払って使用することが大切です。また、履歴削除後、念のためパスワードの変更なども検討すべきでしょう。

③チャット履歴を残さない設定にする

ChatGPTの設定にある「Chat history & training」をオフにすると、チャットの内容がサーバーに保存・学習されなくなります。この設定を有効にすることで、仮にアカウント情報の漏洩や不正アクセスがあった場合でも、過去のチャット履歴から機密情報が流出するのを防げます。

特に業務利用時など、意図せず機密情報が入力されるリスクがある場合には、この設定を常にオフにしておくことで、未然に情報漏洩を防ぐ対策になります。